Er AI klar til at bestemme over liv og død?

Menneskets moralske kompas peger langt fra i samme retning, og retningen kan desuden skifte alt efter, hvilken situation vi befinder os i, hvor hurtigt vi skal beslutte os, og hvilken rolle vi i øvrigt har i situationen. Det viser et nyt, omfattende studie fra en gruppe forskere i forbrugeradfærd og adfærdsøkonomi på Aarhus BSS, og de stiller spørgsmålet: Hvordan overfører vi disse dilemmaer til kunstig intelligens?

15.11.2019 | MICHAEL SCHRØDER

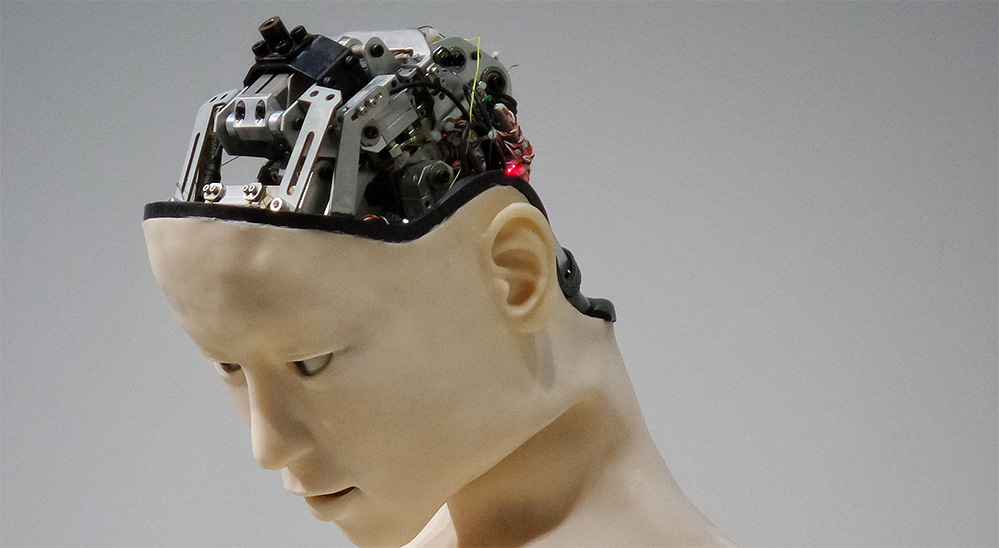

FOTO: Franck V/Unsplash

Mens du læser denne artikel, så tænk engang over følgende spørgsmål:

Forestil dig to typer af selvkørende biler, der hver især nærmer sig fatale situationer, hvor enten fodgængere eller bilernes passagerer vil blive dræbt. Den ene selvkørende bil er programmeret til for alt i verden at beskytte sig selv, sin ejer og sine passagerer. Den anden selvkørende bil er programmeret til at beskytte så mange mennesker som overhovedet muligt uanset konsekvenserne. Hvilken bil vil du selv foretrække at sidde i? Hvilken bil vil du foretrække, at din nabo kører rundt i?

Hidtidige studier på dette felt har vist, at de fleste mennesker hælder til, at den selvkørende bil skal programmeres, så den beskytter så mange mennesker som muligt. Inden for filosofien kaldes denne moralske tilgang for utilitarisme (se faktaboks).

Utilitarisme: Filosofisk retning og moralsk doktrin, der som en konsekvensetik indebærer, at man altid skal handle på en sådan måde, at konsekvenserne af det, man gør, bliver så gode som muligt, dvs. bedre end konsekvenserne af alle andre mulige handlingsalternativer i en given situation, og for så stort et antal mennesker som muligt. Kilde: Gyldendals Den Store Danske |

I det nye studie udfordres denne moralske tilgang imidlertid ved blandt andet at sætte deltagerne i en række eksperimenter under forskelligt tidspres og ved at tildele dem forskellige roller i trafikken – som fodgænger eller som passager i bilen.

"Den moralske beslutning, som vi umiddelbart siger, at vi vil tage, er ikke altid til at stole på"

Darius-Aurel Frank, ph.d.-studerende, Institut for Virksomhedsledelse, Aarhus BSS

Ikke til at stole på

Både tid og rolle kan påvirke vores moralske tilgang til dilemmaer, viser studiet, som er lavet blandt knap 3.000 mennesker i USA og Danmark, fordelt på i alt syv eksperimenter omkring dilemmaer med selvkørende biler.

”Studiet viser, at vores moralske beslutninger slet ikke er så simple, som vi måske troede, og at den moralske beslutning, som vi umiddelbart siger, at vi vil tage, ikke altid er til at stole på,” siger Darius-Aurel Frank, ph.d.-studerende på Institut for Virksomhedsledelse, Aarhus BSS, og førsteforfatter på studiet, som er offentliggjort som en åben artikel i Nature-tidsskriftet Scientific Reports.

Studiet er lavet sammen med lektor Polymeros Chrysochou, lektor Panagiotis Mitkidis fra Aarhus BSS og professor Dan Ariely, Duke University, USA. De har sammen dannet en tværfaglig forskergruppe, der vil dykke nærmere ned i spørgsmålene omkring sikkerhed og etik i udviklingen af design for kunstig intelligens. Nu stiller de spørgsmålet: Hvordan kan disse modsætninger i menneskelig moral overhovedet indarbejdes i kunstig intelligens?

Win-win

At kunstig intelligens – kendt som AI (Artificial Intelligens) - er over os, behøver vi slet ikke længere at diskutere. AI er her allerede, hvad enten vi bryder os om det eller ej, og AI vil få større og større betydning i de kommende årtier i takt med udbredelsen af den fjerde industrielle revolution.

Tanken bag er egentlig win-win for os alle. Maskiner kan tænke både hurtigere og mere præcist end menneskets hjerner er i stand til, så hvorfor så ikke bare overlade tunge og vanskelige beslutninger til maskinerne, læne os tilbage og nyde den øgede effektivitet i beslutningskraft?

”Fordi vi ikke ved, hvordan designerne af kunstig intelligens egentlig tænker. Det er en meget vigtig del af ligningen,” siger Darius-Aurel Frank.

Trolley-dilemma

Når det kommer til beslutninger, der indebærer elementer af moral, hvad er rigtigt, og hvad er forkert, kommer den kunstige intelligens til kort. AI skal trænes til at træffe moralske valg, og det eneste input til maskinerne er den menneskelige moral.

Udgangspunktet for studiet er et kendt, etisk dilemma fra psykologiens verden, det såkaldte Trolley-dilemma (se fakta-boks). I forskellige kombinationer er en række dilemmaer blevet opstillet med inspiration fra open-source-programmet Moral Machines (se fakta boks). I studiet er designet fra Moral Machine blevet anvendt, så resultater kan sammenlignes.

Trolley-dilemmaet: Klassisk, etisk dilemma lanceret at den engelske filosof Philippa Foot i 1967. Dilemmaet er: Du står ved et jernbanespor og ser en løbsk sporvogn komme farende imod fem jernbanearbejdere, som ikke har mulighed for at nå at flytte sig. Du opdager en sporskifter, som du kan trække i, så vognen kører ind på et andet spor, hvor der til gengæld står en enkelt arbejder. Vil du ændre vognens retning, redde fem arbejdere på bekostning af én? I en variant af Trolley-dilemmaet får du mulighed for at skubbe en meget tyk mand ud fra en bro og ned på skinnerne for derved at standse toget og redde de fem arbejdere. Men du slår den tykke mand ihjel. Hvad vil du gøre? Hvis ikke du gør noget, vil de fem arbejdere i begge tilfælde blive slået ihjel. Kilde: The Conversation |

|---|

Konceptet for alle eksperimenter var det samme: En selvkørende bil kommer kørende mod en fodgængerovergang, hvor en fodgænger er ved at passere gaden. I den modsatte kørebane står en betonklods. Situationen er den, at bilen ikke kan nå at standse, før den enten rammer fodgængeren og slår denne ihjel, eller skifter kørebane og rammer betonklodsen, så passageren i bilen bliver slået ihjel.

Sympati for fodgængeren

Deltagerne skal nu vælge, om de vil fortsætte eller skifte bane. For at undersøge om rolle og tid spiller ind på beslutningen, er deltagerne først blevet delt i to: En gruppe, der skulle svare inden, der var gået fem sekunder (intuitiv beslutning), og en anden gruppe, der fik 30 sekunder til at svare (overvejet beslutning). Begge grupper var forinden tilfældigt inddelt i tre rolle-grupper: En fodgænger-gruppe, en passager-gruppe og en kontrol-gruppe, der som udenforstående observerede situationen.

Moral Machine: Et open-source-program udviklet af forskere på MIT, hvor enhver kan gå ind og afprøve forskellige dilemmaer i forbindelse med selvkørende biler. Programmet blev udviklet efter, at forskerne Jean Francois Bonnefon, Azim Sharif og Iyad Rahwan i 2015 i en videnskabelig artikel offentliggjorde en survey omkring de moralske dilemmaer i forbindelse med selvkørende biler. Kilde: Moral Machine |

Dette basis-eksperiment resulterede i, at fodgængeren i de fleste tilfælde slap fra situationen med livet i behold, mens passageren blev ofret. Dog var der signifikante forskelle på resultatet alt efter, hvilke roller deltagerne havde, og hvor lang tid de havde at svare.

Jo længere tid, deltagerne havde til at svare, jo mere blev fodgængeren ofret for alle tre rolle-grupper. Den intuitive beslutning resulterede i gennemsnit i 21,5 pct. fodgænger-dødsfald, mens den overvejede beslutning i gennemsnit slog 36,5 pct. af fodgængerne ihjel.

Forskellene mellem rolle-grupperne var mindre, men stadig signifikante. Fodgænger-gruppen ofrede fodgængeren i 22,8 pct. af tilfældene, mens passager-gruppen ofrede fodgængeren i 32,4 pct. af tilfældene. Kontrol-gruppen ofrede fodgængeren i 30,7 pct. af tilfældene i gennemsnit.

Overordnet var der altså overvejende stemning for at redde fodgængeren og ofre passageren, og det var overvejende kvinder og ældre, der indtog den holdning.

Varianter af samme tema

I de følgende eksperimenter varierede man situationerne over samme mønster.

Man øgede blandt andet antallet af passagerer i bilen, og det betød en kraftig stigning i antallet af reddede passagerer, mens den enlige fodgænger i næsten dobbelt så mange tilfælde som tidligere blev ofret. Størst udsving konstaterede man i fodgænger-gruppen mellem den intuitive og den overvejede beslutning. Mens kun 4,3 pct. af deltagerne i fodgænger-rollen umiddelbart var parat til at ofre fodgængeren, steg det til hele 60 pct., når beslutningen blev overvejet.

Kontrol eller ej

I de efterfølgende eksperimenter testede forskerne, hvordan deltagerne reagerer, når fodgængeren bryder færdselsreglerne i forskellige grader, når der er flere passagerer eller flere fodgængere, og når der er børn blandt enten fodgængerne eller passagererne.

Og i alle tilfælde blev hypoteserne bekræftet: Mennesker er tilbøjelige til at straffe lovovertrædelser, det utilitaristiske moralkodeks er stærkt, og børns liv anses for at være af højere værdi end voksnes.

Men ét resultat kom bag på forskerne.

”I et af eksperimenterne flyttede vi bilens enlige passager fra forsædet til bagsædet, og det gav et markant større antal reddede passagerer på bekostning af fodgængerne. Det gjaldt for deltagerne i både fodgænger- og passager-rollen. Det tyder på, at deltagerne i eksperimentet stadig mener, at en passager på forsædet har mere kontrol over situationen, selv om vi taler om selvkørende biler. Det er interessant, da vi tilsyneladende ikke helt har vænnet os til det fulde koncept af selvkørende biler,” siger Darius-Aurel Frank.

Mere forskning

Der er således nok at tage fat på at diskutere for politikere, filosoffer, forskere og ikke mindst designere af kunstig intelligens.

En algoritme, der alene tager højde for det utilitaristiske moralkodeks er tilsyneladende ikke nok. Der skal mere til. Hvad der skal til, er imidlertid stadig til diskussion, og derfor anbefaler forskerne, at der forskes yderligere i, hvordan vores moralske beslutninger bliver til, og hvad der styrer dem.

”Trolley-dilemmaet, som Moral Machine også er bygget op omkring er for eksempel for enkelt til, at det fuldt ud kan dække de moderne dilemmaer, som selvkørende biler indeholder. For eksempel vil oddsene i den virkelige verden aldrig være fuldstændig ens, som i Trolley-dilemmaet. Et mere realistisk scenarium med mere realistiske chancer for overlevelse vil derfor være et oplagt felt for fremtidig forskning,” siger Darius-Aurel Frank.

Fakta

Læs den originale forskningsartikel

Ph.d-studerende Darius-Aurel Frank, Institut for Virksomhedsledelse, Aarhus BSS